Faktorisierte Tokenisierung in der Bildgenerierung: Ein innovativer Ansatz zur Effizienzsteigerung

KI sauber im Unternehmen integrieren: Der 5-Schritte-Plan

Von der ersten Idee bis zur voll integrierten KI-Lösung – strukturiert, sicher und mit messbarem Erfolg

Strategie & Zieldefinition

Wir analysieren Ihre Geschäftsprozesse und identifizieren konkrete Use Cases mit dem höchsten ROI-Potenzial.

✓ Messbare KPIs definiert

Daten & DSGVO-Compliance

Vollständige Datenschutz-Analyse und Implementierung sicherer Datenverarbeitungsprozesse nach EU-Standards.

✓ 100% DSGVO-konform

Technologie- & Tool-Auswahl

Maßgeschneiderte Auswahl der optimalen KI-Lösung – von Azure OpenAI bis zu Open-Source-Alternativen.

✓ Beste Lösung für Ihren Fall

Pilotprojekt & Integration

Schneller Proof of Concept mit nahtloser Integration in Ihre bestehende IT-Infrastruktur und Workflows.

✓ Ergebnisse in 4-6 Wochen

Skalierung & Team-Schulung

Unternehmensweiter Rollout mit umfassenden Schulungen für maximale Akzeptanz und Produktivität.

✓ Ihr Team wird KI-fit

Inhaltsverzeichnis

Optimieren Sie Prozesse, automatisieren Sie Workflows und fördern Sie Zusammenarbeit – alles an einem Ort.

Faktorisierte Bildtokenisierung und -generierung: Ein neuer Ansatz für effizientere visuelle Modelle

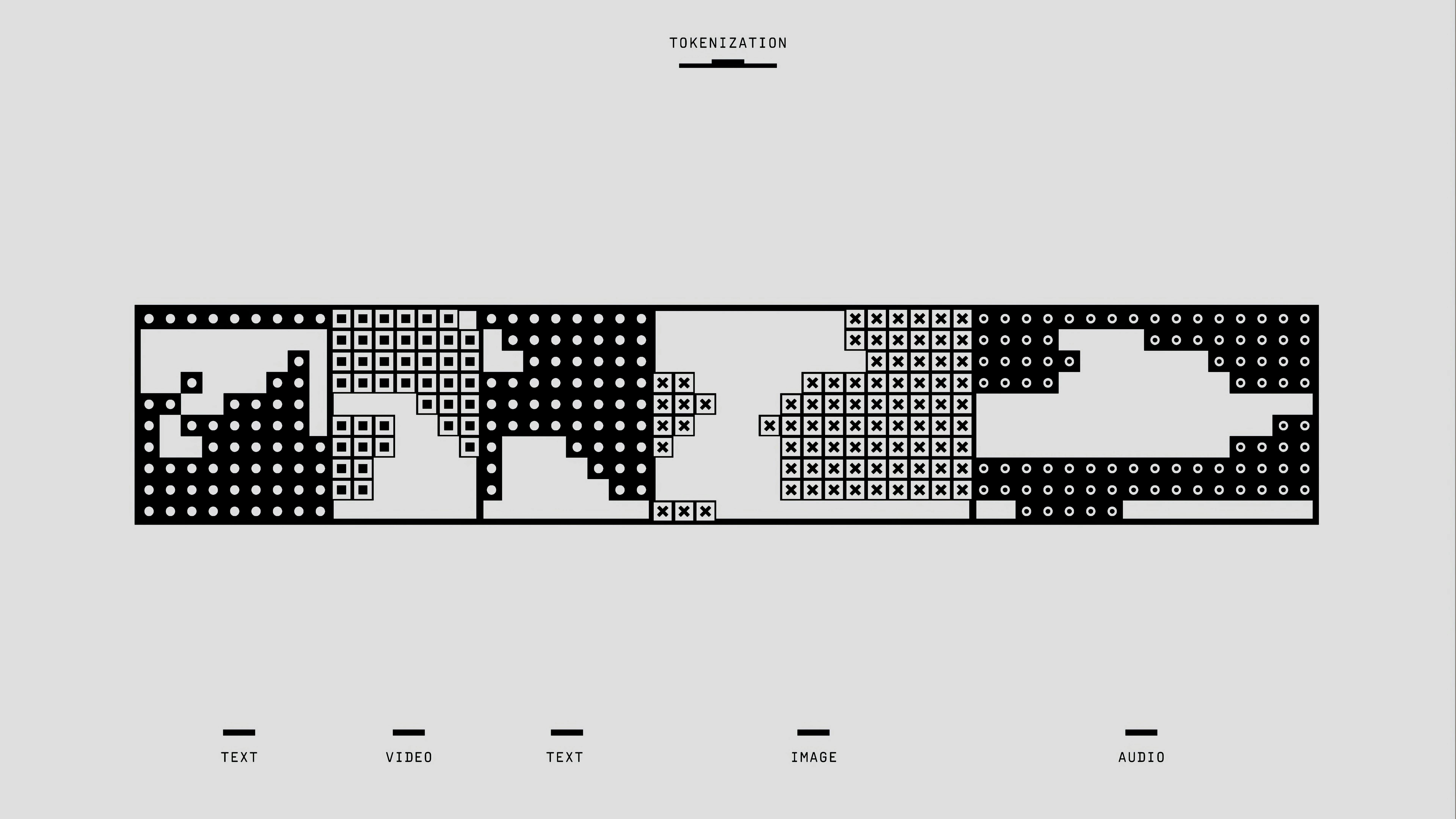

Visuelle Tokenizer spielen eine zentrale Rolle in modernen Bildgenerierungsmodellen. Sie transformieren Bilddaten in diskrete Einheiten (Tokens), die von Transformer-basierten Modellen verarbeitet werden können. Die gängige Methode der vektorquantisierten Tokenisierung (VQ) stößt jedoch bei der Skalierung auf Herausforderungen. Große Codebooks, die für eine detaillierte Bilddarstellung notwendig sind, führen oft zu Instabilität im Trainingsprozess und begrenzen die Performance. Ein neuer Ansatz, die faktorisierte Quantisierung (FQ), verspricht hier Abhilfe.

Faktorisierte Quantisierung: Das Prinzip der Codebook-Zerlegung

FQ zerlegt ein großes Codebook in mehrere kleinere, unabhängige Sub-Codebooks. Dieser Ansatz reduziert die Komplexität der Suche nach dem passenden Token im Codebook erheblich, was zu effizienterer und skalierbarer Tokenisierung führt. Um sicherzustellen, dass jedes Sub-Codebook unterschiedliche und komplementäre Bildinformationen erfasst, wird eine spezielle Regularisierungstechnik eingesetzt, die Redundanz minimiert und die Diversität der Sub-Codebooks fördert.

Repräsentationslernen für semantisch reichhaltige Tokens

Ein weiterer wichtiger Aspekt von FQ ist die Integration von Repräsentationslernen. Vorab trainierte Bildmodelle wie CLIP und DINO werden genutzt, um den gelernten Repräsentationen semantische Informationen hinzuzufügen. Dadurch wird sichergestellt, dass der Tokenizer verschiedene semantische Ebenen im Bild erfasst, was zu aussagekräftigeren und differenzierteren Repräsentationen führt.

Verbesserte Rekonstruktionsqualität und effizientere Generierung

Experimente zeigen, dass Modelle, die auf FQ basieren (z.B. FQGAN), die Rekonstruktionsqualität von Bildern deutlich verbessern und State-of-the-Art-Ergebnisse erzielen. Darüber hinaus lässt sich dieser Tokenizer effektiv in autoregressive Bildgenerierungsmodelle integrieren. Die reduzierte Größe der Sub-Codebooks ermöglicht eine schnellere Verarbeitung und Generierung von Bildern, insbesondere bei höheren Auflösungen.

Eindimensionale Tokenisierung: Ein alternativer Ansatz

Neben FQ gibt es auch alternative Ansätze zur Bildtokenisierung. Ein Beispiel dafür ist die eindimensionale Tokenisierung (z.B. TiTok), bei der Bilder in 1D-Sequenzen von Tokens umgewandelt werden. Dieser Ansatz ermöglicht eine noch kompaktere Repräsentation und führt zu deutlich effizienteren und effektiveren Repräsentationen im Vergleich zu herkömmlichen 2D-Gittern. Trotz der kompakten Darstellung erreicht die 1D-Tokenisierung eine wettbewerbsfähige Performance und bietet Vorteile bei der Generierung von Bildern mit höherer Auflösung, da die Anzahl der zu verarbeitenden Tokens deutlich reduziert wird.

Ausblick: Potenzial für zukünftige Entwicklungen

Sowohl FQ als auch 1D-Tokenisierung stellen vielversprechende Ansätze für die Weiterentwicklung von visuellen Tokenizern dar. Die effizientere Verarbeitung und die verbesserte Skalierbarkeit eröffnen neue Möglichkeiten für die Anwendung von Transformer-basierten Modellen in der Bildgenerierung und anderen Bereichen der Computer Vision. Zukünftige Forschung könnte sich auf die Optimierung der Codebook-Zerlegung, die Integration weiterer vortrainierter Modelle und die Anwendung der faktorisierten Tokenisierung auf andere Datentypen konzentrieren.

Bibliographie: https://arxiv.org/html/2406.07550v1 https://openreview.net/forum?id=gzqrANCF4g https://huggingface.co/papers/2406.07550 https://papers.neurips.cc/paper_files/paper/2022/file/cd062f8003e38f55dcb93df55b2683d6-Paper-Conference.pdf https://arxiv.org/pdf/2205.10093 https://yucornetto.github.io/projects/titok.html https://openreview.net/pdf/9cc7b12b9ea33c67f8286cd28b98e72cf43d8a0f.pdf https://www.researchgate.net/publication/371536798_Tokenization_with_Factorized_Subword_Encoding https://ojs.aaai.org/index.php/AAAI/article/view/28407/28795 https://openaccess.thecvf.com/content/CVPR2024/papers/Gu_Rethinking_the_Objectives_of_Vector-Quantized_Tokenizers_for_Image_Synthesis_CVPR_2024_paper.pdf

.svg)

.png)